¡Hey, qué pasa lector! ¿Qué pasa lectora? Volvemos de nuevo a la carga con un post de SEO muy potente, de los que más me gustan, actualidad y SEO fresco.

Hoy quiero hablarte sobre el último Broad Core Update de Google. Porque salvo que hayas estado aislado en una cueva o perdido en una isla paradisíaca tomando daikiris durante las últimas 3 semanas (¡quién pudiera! ????), sabrás que el 12 de Marzo hubo otra actualización del algoritmo.

¡Y ya van 6 en un año! ¿Nos dejarás vivir tranquilos algún día, maldito «querido» Google?

Quiero contarte mis impresiones, pero también las de otros profesionales y, en general, las de toda la Comunidad SEO.

Así que prepárate, porque vas a poder leer la mayor recopilación de información sobre este Update que existe en un blog de habla hispana (o ese es el intento… vamos a ver si lo conseguimos ????).

De todos modos antes has de saber, lector, que no hay demasiada información clara respecto a esta update y que muchas veces nos basamos en experiencias propias con webs y confabulaciones para respaldar nuestras afirmaciones.

Pero vayamos por partes.

Voy a tratar de poner orden a todo esto antes de liarme a escribir como un loco.

A esta actualización se la ha llamado Florida 2. Sí, ya sabes, los SEOs somos muy fans de ponerle nombre a las cosas. ¿Y por qué ese nombre? Si te pica la curiosidad puedes verlo aquí.

Pero te aviso antes de que te relajes, el nombre es lo de menos. Como todo gran cambio en el Core de Google, aún se siguen notando fluctuaciones a día de hoy.

Esto es algo típico en las actualizaciones del algoritmo. Es como cuando hay un terremoto, primero viene lo fuerte y luego van teniendo lugar réplicas más pequeñas.

¿Ha sido realmente grande este Update?

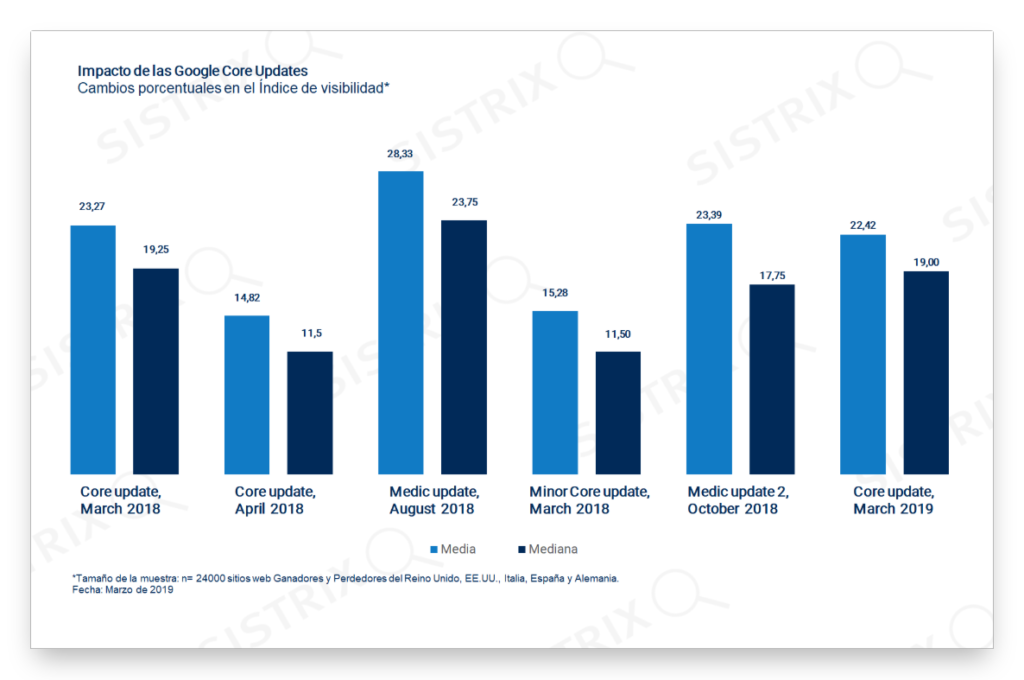

Pues sí, y mucho. Desde Sixtrix han hecho un análisis comparándolo con el resto de actualizaciones del último año.

Te lo resumo.

Ha sido el segundo más grande tras el mal llamado Medical Update de Agosto del 2018. Pero además, extraen otras conclusiones muy interesantes y reveladoras en base a un estudio sobre 24.000 dominios analizados.

¿Te gustan los porcentajes?

Un 40% de esos dominios se han visto afectados una sola vez por alguno de estos 6 updates. Mientras que un 60% dos o más veces.

Y encima, a más de una cuarta parte de los dominios que aparecen en todo el estudio les ha golpeado tres o más veces ????

Parece obvio que Google no está contento con ese 60% de dominios porque no cree que ofrezcan los mejores resultados para sus usuarios. Algo deben tener en común para que la haya tomado con ellos tantas veces, ¿no crees?

Y una cosa que no quiero que se me olvide, porque es importante. Según CognitiveSEO, la volatilidad en las SERPS durante estos últimos 5 meses es mucho mayor en móvil que en desktop. Se puede ver claramente en la gráfica que muestran, donde la diferencia es considerable.

¿Qué dice Google al respecto?

Ya sabemos lo hermético que es Google en estos casos. Pero un par de cosas sí que nos ha dicho.

En primer lugar, desmiente que esta actualización tenga que ver con el Neural Matching, como se ha apresurado a decir un cierto sector de la comunidad.

Y también niega que Penguin haya sido parte de este cambio de algoritmo. Sí, también hay quien dijo que era por eso.

En relación a esto último, el 2 de Abril Google publicó un informe sobre cómo tratan el spam en las búsquedas. Puede ser interesante para entender mejor lo que luego comentaremos sobre los enlaces.

Enlaces fraudulentos: seguimos apostando por los enlaces autorizados y relevantes como una señal importante de posicionamiento en la búsqueda y lidiando rápidamente con los enlaces fraudulentos más graves.

No, no, no…!

Todo son negativas. ¡Hasta han renegado del nombre de Florida 2! Dicen que ellos no le ponen nunca nombre a ninguno de sus cambios. Para Google es simplemente la Actualización del Core de Marzo de 2019. Punto.

¿Qué dice la Comunidad SEO sobre el Update Florida 2?

Pues de momento todo son especulaciones. Como ocurre siempre cuando hay una actualización. Lo más prudente es esperar y pasado un tiempo razonable, empezar a analizar.

Se han formulado muchas teorías hasta ahora.

Las hay para todos los gustos. Hay quien dice que tiene que ver con el EAT (Expertise-Authority-Trustworthiness), algunos que está relacionado con enlaces y, otros, que es un roll back del algoritmo de Agosto de 2018 (un roll back vendría a ser que Google de algún modo está «deshaciendo» los cambios…).

Puede que sea una mezcla de todo ello aunque soy en general poco partidario del roll back, y es muy probable que haya que añadir algún elemento más. Lo que parece obvio es que Google no está teniendo en cuenta un único factor, sino la suma de varios.

Un artículo que te recomiendo que leas al respecto de todo esto es el que escribe Glenn Gabe en su blog gsqi.com.

Muestra un montón de ejemplos de clientes, así como problemas que se detectaron y solucionaron, consiguiendo que con esta nueva actualización esos sitios web subieran como la espuma.

Hay una parte del post donde inserta un vídeo sobre uno de los muchos Hangouts que realiza John Mueller, donde explica que a veces al hacer un cambio de algoritmo se les va de las manos y tienen que “reajustar”, mientras que otras ocurre lo contrario, se quedan cortos y tienen que “endurecer”.

Te lo voy a dar mascado, así que si quieres oír eso, ve hacia el minuto 20.

Google podría estar dando más valor a enlaces potentes y degradando el valor de otro tipo de enlaces, lo cual explicaría las bajadas/subidas tan drásticas que se han producido.

Explica también que Google evalúa el E-A-T de forma algorítmica mediante varios factores, siendo el Page Rank el más conocido (que utiliza los enlaces a través de la web para entender la autoridad).

Esto lo ha confirmado Google como puedes ver en la siguiente captura.

También nos cuenta la importancia de atribuir el texto escrito a un autor experto, especialmente en los nichos YMYL (Your Money Your Life). Posiblemente, que haya una bio que respalde sus conocimientos del sector, enlaces a sus redes sociales, etc…

Pero, ¿cómo detectarlo con un algoritmo? Lo veo complicado .

¿Y qué opinan nuestros colegas SEO de España sobre la Actualización de Google del 12 de Marzo de 2019?

No se ha escrito mucho en nuestro país sobre esta actualización del algoritmo de Google, más allá de lo comentado en Twitter o en foros.

Por eso he querido consultar con algunos colegas profesionales del sector para que nos dieran su punto de vista sobre qué creen ellos que está pasando.

A algunos de los que verás abajo los conozco y los conoces tú también, a otros aún no he tenido la suerte pero son lectores o seguidores de algún modo de mi trabajo y me ha parecido el post perfecto para poder mostrar la opinión de algunos lectores del blog.

Te dejo con ellos ????

Rafa Ramos sobre este Update (lector de B30)

Os cuento un caso real. Un cliente que tenía un tráfico orgánico muy pequeño en 2017, y que en enero de 2018 comenzaba a despegar. El crecimiento fue poco a poco hasta julio de 2018, pero entonces llegó Google con su actualización de Agosto. El crecimiento comenzó a ser exponencial. Parecía que se podía rankear cualquier cosa.

En marzo de 2019, antes de la actualización actual, el tráfico era 25 veces mayor que en julio de 2018. A finales de marzo de 2019, éste ha caído de manera estrepitosa, hasta solo 7 veces el tráfico de julio de 2018.

Era una web a la que no le había prestado demasiada atención.

Ese site comencé a analizarlo en junio, y lo puse en cola, ya que había otras webs con peor rendimiento. Sus cifras eran buenas, y eso hacía que no me fijase demasiado. Sin embargo, este aumento tan grande de posicionamiento me hizo mirarla de forma pormenorizada.

Tenía un buen linkbuilding, pero ahí terminaba todo lo bueno: canibalizaciones, contenido duplicado, contenido escaso, sobreoptimización, falsa verticalidad, carga lenta… lo demás era negativo.

En agosto de 2018 llevaba webs del mismo sector con problemas muy semejantes, pero que estaban siendo tratadas de manera totalmente distinta por Google. Unas estaban en mínimos y otras estaban batiendo récords de máximos.

Y aquí me planteé algo: ¿No es demasiado riesgo hacer una reestructuración total de una web que está arrasando? ¿No me estaría pasando de listo? ¿Habría algún diferencial para que Google tratase de forma tan diferente a estas webs y yo no lo estaba viendo?

Decidí no tocar nada y beneficiarme de la tendencia positiva el mayor tiempo posible, sabiendo que tarde o temprano la manzana caería por su madurez.

Entiendo que Google ha utilizado los mismos criterios, excepto uno: el temporal. Llegaron las mismas correcciones, pero en diferentes fechas. Me explico.

¿Google está cribando poco a poco la Web? ¿Google escanea tantas cosas que lo tiene que hacer por tandas?

Un dato a tener en cuenta es que los sitios corregidos en segundo lugar (tras esta última actualización) lo van a tener más complicado. Básicamente porque muchos de los afectados hace meses, ya están optimizados.Sinceramente, no encuentro otra explicación, solo esta: Google no aplicó la actualización de agosto a todas las webs, y ahora la ha aplicado al resto.

-Rafa Ramos de SoyRafaRamos.com

Daniel Blanco sobre el Update (lector de B30)

El 16 de Noviembre de 2003 Google introdujo un cambio de algoritmo al que se le puso el nombre de Google Florida y que provocó una “masacre” introduciendo cambios muy similares a los que estamos viviendo hoy en día con Florida 2.

Uno de los objetivos más importantes que se pretendía conseguir con ese Update era entender mejor las consultas de los usuarios.

Los principales castigados fueron los sitios web que apuntaban muchos enlaces con la palabra clave exacta a la home.

Afectó especialmente a keywords con un gran volumen de búsquedas y sabemos que fueron muy pocas las long tail que se vieron afectadas.

Esto es precisamente lo que me ha ocurrido en este nuevo update. Mi blog recibía alrededor de 4.500 visitas al día y ha bajado a unas 1.500 diarias.

En la imagen puedes ver cómo disminuye el tráfico a mediados de Marzo.

También te dejo una captura para que veas cómo afectó este cambio a las principales palabras clave de mi web.

Como podrás observar, muchas keywords de primer nivel se van a tomar viento.

Eso me hace pensar que este Update va muy de la mano con la intención de búsqueda, enlaces, velocidad de carga, filtros y sobre todo con la forma en la que los robots de Google entienden los resultados.

Otro asunto es el de los nichos enfocados a diversas temáticas (horizontales). Si Google ha evolucionado y quiere ofrecer una mejor y más concreta experiencia de usuario, lo más normal es que “penalice” a los sitios web donde se hable de diversas temáticas, ¿no crees?

Un claro ejemplo de sitios web con diversas temáticas que han tenido un impacto negativo en las SERPS son los propios periódicos.

Como puedes comprobar, dos de los periódicos más grandes de España (ABC y El Mundo), han perdido bastante tráfico.

Florida 2 no es un simple Update. Se trata de un desafío que cambiará la forma en la que vemos y entendemos el SEO.

-Daniel Blanco de MuyBlogger.com

Juan de Useo sobre este Update (el mejor consultor SEO que conozco ;P)

Pero lo hace de forma algorítmica, con lo cual es inevitable que haya un pequeño porcentaje de justos pagando por pecadores, y viceversa.

Sí puedo decir con seguridad que no ha sido un simple reajuste del update de agosto. Entre las webs que trabajo y que han experimentado subidas significativas (algunas hasta del 200%), hay varias que no fueron afectadas en agosto, y en cambio sí en otros updates, como el de marzo de 2018 (ver pantallazo) o el del 27-28 de septiembre de 2018.

Respecto a las que se recuperan en parte de una caída fuerte en agosto, que en mi caso son webs relacionadas con el sector salud (aunque el mal llamado Medical Update afectó a todos los sectores), los factores comunes que hemos trabajado tienen que ver con keyword stuffing y calidad del contenido en general, así como con el número y tipo de outbound links.

No digo que sea la fórmula secreta para recuperar cualquier web, pero sí son los factores coincidentes en proyectos que han duplicado o triplicado el tráfico que tenían en las semanas anteriores al Update de marzo.

Por otro lado, un factor que se repite en las webs que suben en marzo tras caer a finales de septiembre es el haber auditado su perfil de enlaces y enviarle un buen archivo disavow a Google.

Esto hay que hacerlo con cuidado porque no es blanco o negro; no vas a subir por el mero hecho de enviar un disavow, sino que éste debe incluir los enlaces o dominios adecuados para ser efectivo.

Por último, en los ajustes que ha habido en las semanas siguientes al 12 de marzo, veo (al igual que con el update de marzo de 2018) cierta relación con el CTR orgánico: webs con CTRs por encima de lo normal (descartando búsquedas de marca, claro) parecen ser las que se mantienen arriba, o incluso suben, tras los grandes movimientos iniciales provocados por el update.

Más que una causa en sí, puede ser consecuencia de ese intento de ajustarse mejor a lo que busca el usuario.

En este hilo de Twitter di algunos detalles más sobre cómo habían evolucionado los sitios que trabajo, y este post de Rank Ranger muestra datos muy completos sobre los cambios en las SERPS tras el update.

-Juan Villa de Useo

Edu Coromina sobre el Update (diseñador de B30 y uno de mis mejores amigos)

Y si bien es interesante escuchar a la comunidad, uno siempre tiene que poner la atención en los dominios que ha creado, trabajado y levantado, ya que al tener un conocimiento profundo de los mismos, le será más fácil encontrar un patrón (siempre y cuando cuente con un buen puñado de dominios, de distintos sectores y con diferente naturaleza).

Lo que diré no deja de ser mi opinión, pero es lo que he podido leer de mis dominios:

- No considero que haya sido un Roll Back del Update del 1 de Agosto de 2018 (ahí, jodiendo el inicio de vacaciones a la peña…).

- Tampoco considero que haya sido una revisión/moderación.

Bajo mi punto de vista se trata de una continuación. Todos los «broad updates» que se han sucedido desde el último año (incluso antes, pero ahora es más evidente) van en la línea de mejorar el algoritmo para que responda de forma cada vez más efectiva al llamado EAT (Expertise-Authority-Trustworthiness).

No le veo ningún sentido al Roll Back. Si hay dominios que sufrieron el update del 1 de agosto y ahora se han recuperado es por el trabajo que hicieron posterior a esa caída (¡hemos tenido 8 meses para hacerlo!), un buen ejemplo lo encontramos en el post de Borja Aranda.

Y digo más, estoy convencido de que muchos de vosotros (al igual que yo) aunque no nos viésemos afectados por el update, auditamos nuestros dominios y, por miedo, arreglamos cosas que sabíamos que no estaban del todo bien ????

Lo que sí creo es que el Update de agosto dejó algunos dominios en el limbo y que ahora el Florida 2 los ha sacado de ahí. En mi opinión el 1 y 2 de agosto de 2018 Google atacó los dominios que peores métricas devolvían respecto al EAT y dejó otros que pese a todo y pese a estar mal, no estaban tan mal como los que derribó.

De ese modo, daba un voto de confianza a dominios reguleros para que se pusieran las pilas. Así, Florida 2 es la refinación y continuación del Update de Agosto.

Y por último, un ejemplo curioso. El día 10 de marzo, dos días antes de hacerse oficial, en uno de mis dominios sucede lo siguiente:

5 URLs que posicionaban en primera página para el nicho «dietas/adelgazar» desaparecen de las SERPS, tres días después 7 URLs en segunda página suben a mínimo Top3 (nicho ejercicios/rutinas musculares).

¿Eso qué significa? A mí modo de ver, responde al EAT. Google me está diciendo «Oye, no te creo. No he encontrado referencias suficientes como para aceptar que eres un experto en dietas, pero sí he visto que lo eres en rutinas y ejercicios».

Dicho de otra forma el EAT + responder la intención de búsqueda. Yo creo que el juego anda ahí.-Edu Coromina de EduCoromina.com

???? Aunque lo que viene ahora no es un testimonio directo, no quería dejar de incluir la opinión que nos deja Guillermo Gascón, al que considero un amigo más que un colega de sector, en su podcast Hola SEO episodio 91.

Conclusiones de Guille de HolaSEO sobre el Update

¿Por qué no cree que sea un Roll Back? Básicamente porque muchos dominios que fueron afectados en el anterior, también lo han sido en éste, bajando aún más (aquí corrobora lo que decíamos antes del estudio de SISTRIX).

Y una vez más se reitera en que ha sacudido todos los sectores, no solo el de Salud.

Otro punto muy interesante que nos comenta es que cree que una de las partes más importantes respecto a los cambios que se están viendo en este último Core Update son los enlaces.

Algo ha cambiado en cuanto a la valoración de los enlaces por parte de Google (en esta parte vuelve a coincidir con lo que exponíamos más arriba sobre la opinión de Glenn Gabe en su post sobre la parte del E-A-T).Y por supuesto nos recomienda estar a la última sobre todas las posibles informaciones que salgan al respecto, y ver los análisis que circulan por la comunidad para después compararlos con los nuestros.

-Guille de HolaSEO.net

¿Qué se puede hacer para revertir la situación si me ha golpeado el algoritmo?

…Y lo más importante, ¿Qué puedes hacer para evitar que te pase en un futuro?

Como te decía antes, lo mejor es esperar y después analizar. Muchas veces una bajada en los rankings no implica penalización, sino que otra web lo está haciendo mejor y nos ha adelantado.

No te pongas a hacer cambios como un loco en tu web porque haya bajado si consideras que el SEO «de toda la vida» está bien hecho, pero sí hay una serie de acciones que deberías considerar:

- Revisa tus artículos y comprueba si responden bien a la intención de búsqueda. Porque sí, el user intent es hoy por hoy, vital si quieres posicionar.

- Céntrate en solucionar todos los posibles problemas técnicos (que tu web sea responsive, que cargue rápido, errores de rastreo, 404, etc) y de experiencia de usuario que tengas en tu web.

- Intenta que la publicidad de tu web no sea agresiva para el usuario (que haya demasiada y/o que sea muy intrusiva). Esto va muy unido con la experiencia de usuario (UX), tienes que procurar que ésta sea lo mejor posible.

- Mira tu perfil de enlaces y cuida tu anchor text. Intenta no usar la keyword exacta y sí la de marca o url. Y recuerda, siempre es mejor la calidad que la cantidad, ten esto en cuenta.

- Revisa y lee las Quality Raters’ Guidelines de Google, no porque los Raters influyan en el Algoritmo, sino porque así podrás entender mejor qué es lo que busca ofrecer Google y qué considera una web de calidad. De este modo es como Google prueba los resultados de sus búsquedas para asegurarse de que sus algoritmos están funcionando como realmente quieren.

- Y sobre todo… si quieres rankear para keywords short tail fuertes deberás aprender a trabajar en el EAT, algo que podría ser complicado en según qué nichos.

Un ejemplo de esto es la caída que ha pegado mi blog de Dinosaurioss.com. Caída que se inició con el «Medical» Update del 1 de agosto, tal y cómo puedes ver en la bajada en visibilidad en SISTRIX:

Ahora, justo después de esta nueva update de la que estamos hablando hoy el dominio volvió a subir: es evidente que en este caso es un reajuste de la anterior gran update de agosto, tal y como John Muller dice que en ocasiones efectúan desde Google.

Y si nos fijamos en las keywords que han bajado… ¡sorpresa! todo cobra sentido si lo volvemos a relacionar con el concepto de EAT (Expertise-Authority-Trustworthiness):

«Dinosaurios» ha sido en mi caso la palabra clave que fue más golpeada tanto en el update del 1 de agosto como en este último.

No es casualidad.

«Dinosaurios» es una keyword de, literalmente, decenas y decenas de miles de búsquedas. Incluso algunos cientos de miles de búsquedas si la analizamos a nivel global.

Google me está diciendo que para estar ahí arriba para esa «pedazo» de palabra clave mi meganicho de dinosaurios claramente necesita más «Trust«, más autoridad.

Yo conseguí rankear la palabra clave «dinosaurios» a lo bestia para mostrarlo en Dispara Tus Visitas y en su día lo conseguimos, la llegué a colocar en el Top 1, por encima de National Geographic, de museos y de todo tipo de páginas «oficiales», pero tras los recientes updates, donde Google prima mucho más las páginas «reales» que las páginas con SEO (y cuando digo SEO me refiero a: enlaces, contenido optimizado para la keyword, SEO on page bien estructurado… etc) Google me ha vuelto a bajar para esa palabra clave, volviendo a subir a National Geographic y a los anteriores mencionados.

Esto obedece más a un motivo de ordenación de sus SERPS en base a la evolución del algoritmo que a otro motivo, es decir, el SEO mostrado para rankear ya no solo «dinosaurios» con mi home, sino todo el dominio en general, que es lo que muestro en DTV son las buenas praxis SEO que todo nichero debería conocer. Duermo muy tranquilo por las noches en ese sentido 😉

###

¡Y hasta aquí el post de hoy lector!

Espero que te haya gustado y que hayas disfrutado leyendo tanto como lo hice yo escribiendo.

Pero no te vayas sin contarme cómo te ha ido, comparte tu caso con la comunidad SEO.

¿Te ha afectado la actualización del algoritmo? ¿Has notado cambios en el tráfico de tus webs? ¿Cómo te ha tratado Google? Déjalo en los comentarios para que entre todos podamos sacar conclusiones.

Pronto más.

Dean.

Pole ????

¡Me hacía tanta ilusión esto que me voy a celebrarlo con confeti!

No me lo puedo creer, la chica que va diciendo por Twitter que es mi fan número 1 ha hecho pole!!! 😀 jajaja

Un abrazo amiga

Pd: confeti al poder, sobre todo si te han despedido de tu propia empresa

Que penalicen esta pole

¿un hater de Amanda? 😀

Hola Dean,

pues a mí me pegó fuerte. La verdad que el ritmo de 1 publicación semanal que llevaba hasta Noviembre 2018, lo pausé por exceso de trabajo .. pero las visitas y los ingresos de Adsense más o menos se mantenían ..

Y llegó Marzo, y el bajón fué bastante escandaloso .. hasta una reducción del 70% de ingresos Adsense, y un bajón d evisitas del 50% aprox.

Después de darle un lavado a la web y volver a publicar desde hace 4 semanas, estoy viendo de nuevo mejoras tanto en ingresos Adsense como en visitas, pero aún así sigo por debajo de las cifras que tenía en 2018, el año pasado..

Bueno, solo quería dejar mis reflexiones.

Excelente post como siempre y tendré que revisar con tiempo todos los enlaces y videos que aparecen en él, a ver si pillo algo más que mejorar de mi sitio (que seguro que hay muuuchos aspectos que mejorar XD, pero bueno .. a la marcha).

Saludos!

Buenas David,

Bua! una bajada de ese tipo y sobre todo en la parte de ingresos es bastante dura, la verdad

Ayer hablaba con un lector que me comentaba que su web había pasado de 3.000 euros al mes en Adsense a 900, es una verdadera putada con letras mayúsculas y negrita, me hace pensar

Curioso que las mejoras las notes en función del ritmo de publicación, no sé si asociado a señales de fresnesh o qué, pero normalmente no suele ser uno de los factores más determinantes en SEO salvo en casos muy concretos

Un saludo!!

Buenas!

Solo comentar que me llevé la misma torta que David aunque tenía un nivel de ingresos que no era para tirar cohetes, ha quedado reducido al mínimo.

Estuve bastante tiempo sin actualizar la web, pero no había cambios en rankings.

De un día para otro la mayoría de keywords sufrieron caídas muy importantes.

Yo en lugar de publicar más contenido en esa web me limité a actualizar el que ya había, consiguiendo mejorar un poco la situación, pero no llegando a los niveles anteriores.

Supongo que la leche fue considerable porque era un nicho relacionado con la salud indirectamente.

como iba de linkbuilding ese nicho compi?

Pues creo que muy natural, sin subidas estridentes ni enlaces basura. Lo que ocurre es que la caída justo coincidió con la actualización.

Un saludo!!

pero consideras que tiene enlaces «de autoridad»?

Un poco de todo, pero si que tiene enlaces de autoridad.

También le pudo afectar que poco tiempo antes usaba plugins para AMP, y las principales keywords se mostraban para ese formato de página.

Gracias a toda la comunidad, llevaba unos días esperando un post como este para empezar a valorar que voy a hacer después de Semana Santa.

En mi caso bajé casi un 20% y en la última semana (si aun haber hecho nada, solo actualizar algún post antiguo) se ha recuperado casi la mitad.

Esperemos que se mantenga así la tendencia…

Buenas Jose!

Gracias a ti por valorarlo y pasarte a comentarlo por aquí además

Google está bajando webs y luego subiéndolas muchas veces, si, haciendo cosas raras en este sentido, es un momento bastante dinámico en cuanto a fluctuaciones y webs que suben y webs que caen

Creo que todos los cambios se centran mayormente por los enlaces….tengo varios enlaces desindexados tras las updates y si a esto le sumamos que eliminaron el Submit Url de la search console

Gracias por el feedback Jhoan, hay mucha rumorología en ese sentido

No entiendo muy bien la conclusión final sobre dinosaurioss. De que me sirve tener un SEO onpage tradicional perfecto si ya no es relevante para posicionarse. Al revés, me parece una tontería esforzarse demasiado en tenerlo impoluto si no te va a dar buenos resultados. Me da la sensación de que el seo onpage y técnico pierde fuelle y lo interesante es averiguar como google le da más valor a webs importantes que tienen un "SEO" mediocre o incluso malo. Por lo que he podido ver hasta ahora la cosa creo que va de enlaces sobre todo.

Buenas Jon!

Te cuento mi punto de vista al respecto,

no pierde valor en absoluto 🙂 es más, quizás gane todavía más valor el SEO «de toda la vida» o las «buenas praxis SEO», es más, en post cómo el que publicó Borja Aranda recuperando una web de penalización se refleja aún mucho más este asunto: https://blogger3cero.com/tras-update-1-de-agosto/

Lo que pasa es que para determinadas SERPS / para determinados nichos Google está dando valor por encima incluso de eso al Trust, al EAT o como lo queramos llamar, no sé si me explico

Y si, en gran parte esa última parte está relacionada con los enlaces, pero ojo… ya no con cualquier enlace,

Profundicé mucho más sobre esto último en el post análisis del update del 1 de agosto, que creo que es uno de los más completos que hay sobre el tema publicados: https://blogger3cero.com/update-1-de-agosto/

Antes de leer, que tengo un dolor de cabeza primoroso, no os metáis con Florida 2, que mola mucho XD. Hablando en serio, estos cambios bruscos lo mismo te dan un disgusto que un alegrón. Me vais a matar, pero a mí me pilló con el blog de potis patas arriba, con un problema de velocidad de carga serio, y aún así me dio un empujón de los buenos. No quiero pensar cómo estarían los otros…

Y, antes de leer, en vista de lo sucedido, creo que ha tenido en cuenta el author rank y/o la antigüedad de dominios no penalizados. Y, pese a que se haya desmentido, parece ser que se ha cebado con micronichos amazon, tal vez por contenido pobre o tal vez, como decía la autora de Yo Blogueo, porque la API consume muchos recursos de google, con tanto nicho que nace.

Mapache power!!! tengo audios pendientes tuyos, prometo que este mes los respondo a todos jajajaja

Curioso, se me ocurre que eso puede ser (y solo estoy SEO-teorizando) porque otras webs más grandes y relevantes de tu sector cayeron y fueron penalizadas, webs que si son de algún modo más tenidas en cuenta por Google o rastreadas con mayor frecuencia, lo cual puede repercutir en el tráfico de sites más pequeños, dado que el SEO es un sistema de Suma 0, es decir, el tráfico no es infinito, si no se lo llevan unos se lo llevan otros

Enhorabuena os lo habeis trabajado como siempre. Sencillamente genial e interesante. Gracias

¡Gracias! Curramos mucho para que este blog sea lo que es, y no solo yo ni mucho menos 🙂

Leído, me inclino por E-A-T con más cosas, porque el Medical también benefició al mismo sitio, aunque de forma discreta.

¿Cómo sabe google quién escribe? Pues con los rich snippets si se cubren, por ejemplo, o con el propietario del dominio. Tal vez, incluso, por quién tiene las cuentas de analytics y GSC. Es google, neños/as, solo le falta saber si cuando hay una página abierta la estamos mirando de verdad o no 😛

En efecto, en las web YMYL ha habido mucho movimiento, peor es que hay muchas con información errónea. ¿Y si están comparando datos con webs, pongamos, de universidades o con la wiki? Muchos sitios se hacen llamar de salud y son un cúmulo de despropósitos pseudocientíficos. A google no le costaría mucho saber cuáles son, por poner un ejemplo.

PD: Me descoloca que haya penalizado a prensa digital.

Buen coment Mapache, yo también me inclino por EAT

En todo caso, conocer al detalle y de forma científica y al detalle de cómo lo mide me parece uno de los mayores misterios del SEO del momento presente

Excelente post Dean, comparto al 100% las recomendaciones.

Me parece que en estos casos esta bueno esperar que pase un poco la tormenta, sobre todo para hacer grandes cambios. Pero bueno, que seria del SEO sin experimentar aunque sea un poco!

Abrazo!

Gracias compi! la gente que veis opinando arriba son gente que se pelea todos los días con Google y con el SEO así que yo también les doy bastante credibilidad

Un abrazo

A mi en una de mis webs me han crujido…. he perdido dos tercios del tráfico, casualmente el mismo que había ganado con el medicado update de Agosto. ????.

En otros dominios/webs, salvo en una que sí he notado algo de subida, no ha sido relevante.

Reajuste, en ese caso tiene toda la pinta de reajuste por parte de Google

Muy buen artículo Dean! Tenía tiempo sin pasarme por acá. Off topic…por qué Edu Coromina no tiene foto??? Saludos desde Buenos Aires 🙂

¡Romi! 😀

Jajaja, estaba castigado

la verdad es que se me ha pasado, y tiene delito, 3 / 4 personas miran o supervisan de algún modo mis contenidos, jajaja

gracias por el aviso compiiiiii

Muy buen artículo, para los que no entendemos nada pero utilizamos el sentido común en nuestras webs, esto corrobora que realmente Google cada vez se parece más a las personas. Muchas gracias Dean por compartir 🙂

Gracias a ti Luis!

Google evoluciona… los SEOs tenemos que seguirle el ritmo y para eso estamos aquí

Hola Deam

Mi caso es bastante peculiar: Micronicho en Amazon (un «unicornio») Con el update de Marzo sufrió una caída del 70%.

Como no sabía en que podia mejorarle (velocidad de carga de la web buena, seo bien hecho, buen contenido) no le toqué ni una «coma». Con el update de Septiembre se recuperó totalmente e incluso se incrementó su trafico en un 30% mas lo que tenía en su «vida normal»

Update de Agosto: Caída en picado y sigue cayendo…una semana mas y ahrefs mostrará «encefalograma plano»

¿Que hacer? Ni idea….

Pero me da que Google está clasificando las webs por la «reputación» de su autor…es decir, si el piensa que es real, lo premia y sino lo manda a los infiernos…

¡Hola Kino!

el tema de reputación del autor va de la mano del concepto EAT

Yo tengo claro en un 90% que va en esta dirección a lo bestia, el problema es saber identificar de manera real dichos patrones EAT y luego saber potenciarlos

Por ejemplo, dentro de esos posibles factores, en lo personal, dudo mucho que el autor juegue un papel determinante a corto plazo ya que medirlo de manera algorítmica es más complicado

Te mando un email 😉

Hola Deam…

Releyendo tu post…me he dado cuenta que me decias que me mandabas mail…upsss pues o no ha llegado o me lo he «comido»…que yo recuerde no me llegó nada tuyo

saludos…

creo que mandé el email a la persona equivocada, o eso o estaba tu email mal porque sí se que lo he mandado jeje

reenvío

Fantástico post Dean, mucho más completo que ninguno de los que, hasta la fecha he leído. A mí, como bien dices, nos ha golpeado en varias webs de clientes varias veces (entre 3 y 6) y ha habido de todo: la mitad han caído para, en un mes aprox. volver a subir poco a poco y, en el resto ha mejorado sustancialmente el posicionamiento. Sólo ha habido una web de bebés que cayó y está costando levantar y eso que tiene un contenido de calidad y buenos enlaces. En resumen, sí que se ha notado y mucho el cambio o actualización del algoritmo. Gracias por el post, por lo menos veo que es real y la volatilidad de los serps es real y no sólo a mi. Como siempre, una información preciosa y de alta calidad.

Buenas «SEO» 😀

Gracias! hemos trabajado mucho en el contenido empezando por los SEOs invitados

Es tal cual dices compañero, la palabra «volátil» es lo que más define a las SERPS en los últimos tiempos

Suben y bajan, bajan y suben, esa web de bebés me juego lo que sea a que (a pesar de tener «buenos enlaces») no tiene el nivel de «autoridad» suficiente con respecto a su competencia para sus mismas palabras clave

Buen articulo,

En una web afectada por el update de Marzo, la caída está siendo tremenda (y sigue a día de hoy).

El SEO Onpage y Offpage no es malo, lo único que puede pecar la web es de contenido de no muy alta calidad.

Tendremos que esperar un poco y no volvernos locos para ver que pasa.

Saludos.

Dale caña y si ves cambios nos cuentas por aquí !

Otro punto de vista es el de los que estamos empezando con esto. Yo, con mi primer proyecto, tratando de entender toda la movida SEO, arrancon con una página de informción sobre un tema en marzo. Nada más publicarla, con mi Keyword principal me dice DINORANK en su «tracking de posiciones» esto:

31/03/2019 – Puesto 61

1/04/2019 – Puesto 76

2/04/2019 – Puesto 72

3/04/2019 – Puesto 49

4/04/2019 – Puesto 45

5/04/2019 – Puesto 52

6/04/2019 – Puesto 63

7/04/2019 – Puesto 49

8/04/2019 – Puesto 59

9/04/2019 – Puesto 55

10/04/2019 – Puesto 80

11/04/2019 – Puesto 64

La gráfica es una etapa de montaña del Tour. Y bueno, no sé si esto es normal en el arranque de una web o igual es que esto del update me ha pillado justo en mi fase de aprendizaje y en este momento Google no sabe dónde narices ubicar mis historias. En fin. Os sigo atentamente.

No te preocupes por eso en principio 🙂

ese es el típico movimiento por debajo de las SERPS de una web que empieza

Aún casi invisible a los ojos de Google, es decir, no estará expuesta a las fluctuaciones por algoritmo de una forma tan bestia como webs que ya tienen cierto posicionamiento

Aún debe subir 🙂

Enhorabuena Dean por el magnífico post una vez más y gracias a todos los invitados por compartir su experiencia sobre cómo ha afectado el algoritmo a sus webs e intentar arrojar algo de luz de las razones de los cambios de rankings.

Mis observaciones hasta ahora coinciden en que el perfil de enlaces entrantes, es decir, el perfil de backlinks es importante cuidarlo de forma constante cara a estar preparados antes un update de este tamaño y fuerza, así como en la parte de OnPage, indicar y respaldar la autoría de los artículos de que un blog, ya sea corporativo o personal también contribuye a mejorar el concepto EAT de manera interna.

Por último, intentar dar siempre una buena respuesta a la intención de búsqueda del usuario acompañado de una buena UX es fundamental para ocupar primeras posiciones. (no digo nada nuevo pero creo que todo al final se reduce a esto último)

Tener como referencia las Search Quality Evaluator Guidelines ayuda enormemente para conseguirlo.

Un abrazo.

Hola Mika !

Las famosas Guidelines… tenemos que hablar a ese respecto y lo sabes 😉

Aportaría muchísimo a la comunidad SEO

Así es, vamos a ver si poco a poco conseguimos ir sacando aún más información

Me parece como si google se hubiera roto con este update, me gusta mucho buscar información muy diversa y en según qué sectores hace unas semanas que ya no muestra información relevante…

Google está un poco «tonto»

Por ejemplo, muchas de las keywords que yo respondía super bien antes me las ha tirado porque «le ha salido de las pelotas» (hablando mal y pronto) ya que sabemos que Sí respondían bien a la búsqueda

Un ejemplo, la keyword «dinosaurios para niños» teníamos un post Top 1 con contenido en texto y vídeo, una guía para profesores de primaria y prescolar super chula, con actividades para los niños incluso

Me consta que ese post ha sido usado en colegios como soporte más de una vez

Ahora Google decide que por «Trust» mi web para esa query no debe aparecer y solo pone vídeos de dibujos

Reordenación de las SERPS, pero cuando es a un nivel tan masivo es fácil en mi opinión no hilar muy fino muchas veces (de ahí los frecuentes reajustes posteriores)

Gran post Dean. Sigo analizando datos, pero también pienso que todo se mueve en dirección al EAT.. Cada vez más difícil el SEO, todo un reto seguir posicionando. Gracias por tu blog! Un saludo.

Gracias Fran

Personalmente me da respeto ese tipo de mensaje, nada, simplemente seguiremos evolucionando los SEOs como lo hemos hecho siempre a la par que Google 🙂

un abrazo

Buenas Dean!!

Super importante tener presente que siempre que hagamos las cosas White Hat e intentando dar el máximo valor posible y ofrecer la mejor experiencia de usuario, así no habrá penalización que nos tumbe. Al final este siempre acaba siendo el denominador común de lo que busca Google!

PD: Hablando ahora sobre cosas Black Hat, quiero atacar una palabra clave muy suculenta con bastante competencia con una web de DA = 9. Realmente necesitaré usar todo el seo que sé para rankear lo más alto, así que me preguntaba si enviar trafico pagado a través de referral solamente a esa URL (unos 5k- 10k) durante los 2 primeros meses, cuando la web tiene 1.5k de visitas al mes mejoraría o empeoraría la estrategia. Bajo mi punto de vista, a los ojos de Google cantaría mucho y obviamente me lo penalizaría de una forma u otra… Pero mejor contar con la opinión de un experto jejeje. Qué opinas?

Aquí abajo te dejo la estrategia completa, por si le quieres echar un ojo:

-Crear mini cluster de contenido (3 posts) para rankear 3 palabras clave principales de temática similar. (usaré por primera vez contenidoparaseo.com! A ver que tal ejejjeje)

-Título, meta info, rich snippets, interlinking, etc. Indexar + forzar indexación.

-compartir por redes sociales (quizás 2-3 dias de anunciante de pago)

– Esperar 1 semana y enviar trafico + empezar con linkbuilding de bajo nivel + 1 o 2 enlaces fuertes + simular (si no los hay) comentarios e interacción en el post.

– Añadir, modificar, spinear contenido para favorecer el fresh content y mejorar la experiencia de usuario, negrita en palabras clave, controlar keyword stuffing, etc.

Que te parece? Realmente estoy ilusionado a ver que se le puede hacer. Será mi mini concurso particular jejejeje

Buenas Martí!

te contesto muy rápido 🙂

no canta si simulas viralidad o si consigues hacerlo creer a Google que esa Url es viral o lo que es lo mismo, que ese tráfico nuevo e interacción sea lo más natural posible

Hola crack,

A mí en particular este cambio de algoritmo no me ha afectado de forma negativa. Más bien diría que tengo un tráfico constante desde hace al menos 2 años.

En MarketingBlog tengo un tráfico entre 2000-2500 visitas diarias e incluso en Enero (sí, como lo oyes) llegué a alcanzar 2700 visitas.

¿Cuál es mi conclusión? Pues que si desde un principio te basas en el White Hat SEO, no tienes por qué sufrir penalizaciones severas.

Es cierto que puedes tener bajadas mínimas y subidas repentinas, pero esto siempre ha pasado y seguirá pasando.

Yo siempre he apostado por la naturalidad y nunca me ha fallado.

Creo que esa es una de las claves más importantes a tener en cuenta.

Un abrazo 🙂

Gracias por compartir tu experiencia Jony!!

me consta que has hecho un muy buen trabajo con marketingblog y al final una gran parte de ese tráfico se debe a un buen keyword research por tu parte 🙂

La verdad es que he trabajado mucho el SEO On Page, mucho enlace interno y sí, con mucho keyword research también.

A mí me encanta el SEO y prácticarlo.

La verdad es que apenas le he hecho link building, pero de todas formas el tráfico ha llegado jeje

¡Buenas!

En mi web (nicho de tecnología) el tráfico me ha bajado en torno a un 35%, pero a partir del 2 de abril… Así que no sé si achacarlo a este update o no. ¿Creéis que es posible este «efecto retardado», en lugar de un cambio inmediato tras la actualización?

Si, creo que puede tardar algún día en notarse más

puede que la bajada incluso se deba a que poco a poco está subiendo por ejemplo alguien de tu competencia uy por tanto a ti te tocaría perder ese tráfico

A mi me afectó para bien el updated de Marzo. Mi blog aumentó sus visitas un 40-50% y con ese aumento subieron las ganancias en Adsense.

Un mes después parece que las cosas se van asentando.

No tengo el mismo porcentaje de visitas que en Marzo pero este sigue más alto que meses anteriores.

Mi blog es sobre tecnología y no soy ningún experto en SEO, tan solo procuro seguir una pautas básicas en mi web y antes de publicar hago un estudio de las búsquedas y posibles palabras claves que puedo utilizar.

También utilizo Yoast como guía en los artículos.

Otra cosa que suelo hacer es actualizar artículos añadiendo palabras obtenidas de búsquedas que llevan al artículo y actualizando la fecha.

Saludos

Buenísimo! en ese caso por lo que comentas (y no es seguro ni mucho menos, solo una posibilidad) da la sensación de que te lo dio porque webs directas de tu competencia cayeron y tú te llevaste ese tráfico

Si luego Google hace reajuste y devuelve un poco de ese tráfico perdido a webs de la competencia tú lo volverías a perder

Yo con un nicho que estaba recibiendo unas 2000 visitas diarias orgánicas, paso a tener 500 y esto fue por el 11 de febrero, tras analizar que me está tirando abajo, lo único que e notado y puedo aportar, es que las únicas que se quedaron en el top 1 son las transaccionales. Tras analizar a la competencia Vi que algunas de las Webs que se roban los top 1 al pasarlas por el pagespeed dan números muy bajos unos 15/100 para móvil, lo que descarta un problema de velocidad ya que tengo unos 55/100 en movil.

Otro dato interesante, es que mis palabras claves rankeadas, cayeron solo para las búsquedas en movil.

A seguir trabajando.

Un saludo amigos desde Uruguay cuchotattoo

Espero que Dean este de acuerdo conmigo, todo lo que he analizado con PageSpeed me hace pensar que este medidor de velocidad no es apto para analizar las web en el formato mencionado…

Google esta últimamente muy inestable, es mejor esperar y analizar los resultados antes de tomar decisiones importantes con tu sitio. Lo que si esta claro es que no se trata del contenido, porque yo creo contenido basado en cantidad de palabras / keywords y he sido azotado por el algoritmo.

Cada vez tengo más claro que se trata de un "Roll Back" del anterior, de hay a que se muchas webS estén recuperando y otras que se beneficiaron estén perdiendo "cómo la mía".

Aunque, no es seguro, porque si la query ha respondido bien a una consulta de primera hora, ¿porqué parece que ahora no lo hace?.

Espero que te ayude mi valoración sobre el tema y que la fuerza te acompañe!! 😉

Una información muy interesante la verdad. Yo desde diciembre-enero llevo notando que el tráfico orgánico de mi blog, https://josealvargonzalez.es , ha aumentado bastante la verdad. En comparación claro, sigue siendo un tráfico muy pequeño. Lo que está claro, es que Google es cada vez más y más exigente, y el buen trabajo acaba surgiendo efecto, y el black acaba penalizando.

¡Un gran artículo!

Un saludo,

Gracias por dejar tu feedback Jose!

Hola Dean,

En primer lugar me gustaría decir que me encanta tu blog, lo acabo de conocer y me parece una pasada!

Quería hacer una consulta, seguramente no sea el post indicado ya que no cuadra con el tema a tratar.

Te explico, tengo una web para la adopción de animales llamada Miwuki, se compone de un dominio principal (https://www.miwuki.com/) que actúa como página corporativa, donde explicamos en que consiste el proyecto (además cuenta con un blog) y un subdominio (https://petshelter.miwuki.com/) que consite en la app web donde se pueden ver todos los animales en adopción. Los títulos, metadescripciones y keywords están meticulosamente analizadas para cada uno de los enlaces (por ejemplo perros en adopción Madrid).

El tema esta en que los enlaces del dominio principal (miwuki.com) se posicionan super rápido, en menos de 2 días conseguí posicionar en primer lugar las keywords (dar perro en adopción / dar gato en adopción), mientras que las páginas para el subdominio me esta costando horrores posicionarlas.

El tema esta en que el DA (39) del dominio y subdominio es igual…

¿Alguna idea para que las páginas del subdominio se posicionen igual que las del dominio principal?

Un saludo!

Yo estoy convencido de que uno de los factores más importantes es la autoridad de las personas que trabajan en la página.

Por ejemplo, tengo un sitio en el nicho de finanzas, así que invité a algunos contadores y financieros a ser parte del equipo editorial: una forma rimbombante de tenerlos en una página donde aparecen sus nombres y credenciales.

Mi impresión es que esto es lo que está buscando Google: más personas «reales», que hablen de un tema, y que tengan un cierto reconocimiento en el nicho del que están hablando.

busca personales reales y sobre todo webs reales, de autoridad, está jodido el tema del EAT

Saludos cordiales:

Autoupdate. Bueno, pues ya he conseguido una fórmula para en un micro sector, dentro del sector de la medicina, pasar por el aro de Google. Sinceramente, creo que es lo que nos queda. Averiguar el concepto de entidad y tratar de buscar el contenido que responde a la intención de búsqueda de dicha entidad. Básicamente es responder a las preguntas que se hace el usuario. Me ha llevado bastante tiempo.

Cada micro sector es un mundo, y averiguar las preguntas es un dolor de cabeza. Creo que sin una buena herramienta, esto es imposible. A modo de resumen: ver para una intención de búsqueda los mejor posicionados y ver a qué están dando respuesta. Aquí hay 0 trucos.

buenas Rafa! eso te lo dan herramientas como DinoRANK o SEOlyze, comparto que es una parte importante, aunque yo creo que una gran parte de las últimas updates van por la parte del linkbuilding

Dean, esas no las he probado (me las apunto para julio), pero con Sistrix, SEMrush y AHrefs se hace una aproximación a la entidad y a las intenciones de búsqueda. Por cierto, la intención de búsqueda parece que va cambiando, pero no.

Me explico, sabemos la intención de búsqueda por las SERPs, pero si cambian los resultados de las SERPs… pues cambia el contenido que debemos ofrecer. Es algo realmente curioso, pero necesitamos tiempo para saber si lo posicionado es lo correcto (estable) o lo menos malo (poca estabilidad).

Echando la vista atrás, creo que acertamos bastante. Como ya adelantábamos Juan González y yo, había un componente raro que permitía que webs con los mismos errores no se vieran tan afectadas como otras.

Mi razonamiento era un componente temporal, que Google había barrido una parte de la web, y que pronto llegaría al resto. Sea como fuere, así pasó y posteriormente Google hizo otra correción. Todas las webs con los mismos errores fueron tratadas del mismo modo.

En estos momentos, creo que salvo algunos aspectos de las búsquedas locales, tenemos los SEO claro cómo debemos actuar.

Sinceramente creo que google lo tiene muy complicado y muchas veces comete errores bastante grandes últimamente es muy extremadamente difícil posicionar ni siquiera con buen contenido

Saludos

la cosa está complicada en algunos nichos, así es, pero para eso estaremos los SEOs 🙂 para tratar de aportar algo de luz en este sentido

Pues si esa es la idea, llevo en esto desde que soy un niño y he pasado por muchas cosas hasta el di de hoy y sinceramente tal como veo hoy el panorama se pone muy complicada la tarea cada día, es verdad que tarde o temprano llegan los frutos si se hace de manera organizada y con paciencia, paciencia que no todo el mundo tiene pero esa es la que toca a día de hoy.

Saludos desde Miami y felicitaciones por tus éxitos

Miami, que sitio tan espectacular 🙂 algún día lo conoceré,

Saludos compañero

Cuando quieras estás invitado, me gustaría charlar contigo personalmente podrías mandarme un email a contact@webmediums.com

Un saludo

solo la invitación ya me honra 🙂

tienes redes sociales o algo donde también te pueda ver? 😀 jaja

Clar amigo, preferiria darte ese dato en privado si prefieres, un saludo tienes mi correo ahi te mando los datos que necesites.

un saludo

Genial el post